Аналитическая обработка данных. Способы аналитической обработки данных. Обзор и анализ программных технологий разработки WEB-приложений для аналитической обработки данных

8.3.1. Средства On-Line Analytical Processing (OLAP)

On-Line Analytical Processing - средства оперативной (в реальном масштабе времени) аналитической обработки информации, направленные на поддержку принятия решений и помогающие аналитикам отвечать на вопрос «Почему объекты, среды и результаты их взаимодействия такие, а не другие?». При этом аналитик сам формирует версии отношений между множеством информации и проверяет их на основе имеющихся данных в соответствующих базах структурированной информации.

Для ERP-систем характерно наличие аналитических компонент в составе функциональных подсистем. Они обеспечивают формирование аналитической информации в режиме реального времени. Эта информация является основой большинства управленческих решений.

Технологии OLAP используют гиперкубы - специально структурированные данные (иначе называемые OLAP-кубами). В структуре данных гиперкуба различают:

Меры - количественные показатели (реквизиты-основания), используемые для формирования сводных статистических итогов;

Измерения - описательные категории (реквизиты-признаки), в разрезе которых анализируются меры.

Размерность гиперкуба определяется числом измерений для одной меры. Например, гиперкуб СБЫТ содержит данные:

Измерения: потребители, даты операций, группы товаров, номенклатура, модификации, упаковки, склады, виды оплаты, виды отгрузки, тарифы, валюта, организации, подразделения, ответственные, каналы распределения, регионы, города;

Меры: количество плановое, количество фактическое, сумма плановая, сумма фактическая, платежи плановые, платежи фактические, сальдо плановое, сальдо фактическое, цена реализации, срок исполнения заказа, сумма возврата.

Такой гиперкуб предназначен для аналитических отчетов:

Классификация потребителей по объемам покупок;

Классификация продаваемых товаров по методу ABC;

Анализ сроков исполнения заказов различных потребителей;

Анализ объемов продаж по периодам, товарам и группам товаров, регионам и потребителям, внутренним подразделениям, менеджерам и каналам сбыта;

Прогноз взаиморасчетов с потребителями;

Анализ возврата товаров от потребителей; и т.д.

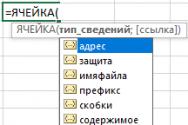

Аналитические отчеты могут иметь произвольное сочетание измерений и мер, они используются для анализа принимаемых управленческих решений. Аналитическая обработка обеспечивается инструментальными и языковыми средствами. В общедоступной электронной таблице MS Excel представлена информационная технология «Сводные таблицы», исходными данными для их создания являются:

Список (база данных) MS Excel - реляционная таблица;

Другая сводная таблица MS Excel;

Консолидированный диапазон ячеек MS Excel, расположенных в одной и той же или различных рабочих книгах;

Внешняя реляционная БД или OLAP-куб, источник данных (файлы формата.dsn, .ode).

Для построения сводных таблиц на основе внешних БД используют драйверы ODBC, а также программу MS Query. Сводная таблица для исходной БД MS Excel имеет следующую структуру (рис. 8.3).

Макет сводной таблицы имеет следующую структуру данных (рис. 8.4): измерения - код подразделения, должность; меры - стаж работы, оклад и премия. Ниже представлена сводная табл. 8.2, которая позволяет проанализировать связь среднего стажа работы и оклада, среднего стажа работы и премии, оклада и премии.

Таблица 8.2

Сводная таблица для анализа связей

Окончание табл. 8.2

Для продолжения анализа средствами сводной таблицы можно:

Добавить новые итоговые показатели (например, средний оклад, средняя сумма премии и т.п.);

Использовать фильтрации записей и итогов сводной таблицы (например, по признаку «Пол», который помещается в макете в область * Страница»);

Вычислить структурные показатели (например, распределение фондов оплаты труда и фонда премии по подразделениям - с помощью средств дополнительной обработки сводных таблиц, доли от суммы по столбцу); и т.д.

Совокупность программ MS Office позволяет публиковать данные электронных таблиц, включая сводные таблицы и диаграммы в формате XTML.

Компонент Microsoft Office Web Components поддерживает работу с опубликованными данными в среде Internet Explorer, обеспечивая продолжение анализа (изменения структуры данных сводной таблицы, вычисление новых сводных итогов).

8.3.2. Средства Data Mining (DM)

Средства DM подразумевают извлечение («раскопку», «добычу») данных и направлены на выявление отношений между информацией, хранящейся в цифровых базах данных предприятия, которые аналитик может использовать для Построения моделей, позволяющих количественно оценить степень влияния интересующих его факторов. Кроме этого, такие средства могут быть полезны для построения гипотез о возможном характере отношений информации в цифровых базах данных предприятия.

Технология добычи текстовых данных (Text Mining - ТМ) представляет собой набор инструментов, позволяющий анализировать большие наборы информации в поисках тенденций, шаблонов и взаимосвязей, способные помочь в принятии стратегических решений.

Технология Image Mining (IM), содержит средства для распознавания и классификации различных визуальных образов, хранящихся в базах данных предприятия или полученных в результате оперативного поиска из внешних информационных источников.

Для решения проблем по обработке и хранению всех данных используют следующие подходы:

1) создание нескольких систем резервного копирования или одной системы распределенного документооборота, которые позволяют сохранять данные, но обладают медленным доступом к сохраненной информации по запросу пользователя;

2) построение Интернет-систем, обладающих высокой гибкостью, но не приспособленных для реализации поиска и хранения текстовых документов;

3) внедрение Интернет-порталов, которые хорошо ориентированны на запросы пользователей, но не обладают описательной информацией относительно загружаемых в них текстовых данных.

Системы обработки текстовой информации, свободные от перечисленных выше проблем, можно разделить на две категории: системы лингвистического анализа и системы анализа текстовых данных.

Основными элементами технологии Text Mining являются:

Суммаризация (summarization);

Тематический поиск (feature extraction);

Кластеризация (clustering);

Классификация (classification);

Ответ на запросы (question answering);

Тематическое индексирование (thematic indexing);

Поиск по ключевым словам (keyword searching);

Создание и поддержка офтаксономии (oftaxonomies) и тезаурусов (thesauri).

К программным продуктам, реализующим технологию Text Mining, относятся:

IBM Intelligent Miner for Text - набор отдельных утилит, запускаемых из командной строки, или скиптов; независимых друг от друга (основной упор делается на механизмы добычи данных - information retrieval);

Oracle InterMedia Text - набор, интегрированный в СУБД, позволяющий наиболее эффективно работать с запросами пользователей (позволяет работать с современными реляционными СУБД в контексте сложного многоцелевого поиска и анализа текстовых данных);

Megaputer Text Analyst - набор встраиваемых в программу COM - объектов, предназначенных для решения задач Text Mining.

8.3.3. Интеллектуальные информационные технологии

Сегодня в области автоматизации управления анализ информации доминирует на предварительной стадии подготовки решений - обработки первичной информации, декомпозиции проблемной ситуации, что позволяет познать лишь фрагменты и детали процессов, а не ситуацию в целом. Для преодоления этого недостатка надо научиться строить базы знаний, используя опыт лучших специалистов, а также генерировать недостающие знания.

Использование информационных технологий в различных сферах человеческой деятельности, экспоненциальный рост объемов информации и необходимость оперативно реагировать в любых ситуациях потребовали поиска адекватных путей решения возникающих проблем. Эффективнейшим из них является путь интеллектуализации информационных технологий.

Под интеллектуальными информационными технологиями (ИТТ) обычно понимают такие информационные технологии, в которых предусмотрены следующие возможности:

Наличие баз знаний, отражающих опыт конкретных людей, групп, обществ, человечества в целом, при решении творческих задач в определенных сферах деятельности, традиционно считавшихся прерогативой интеллекта человека (например, такие плохо формализуемые задачи, как принятие решений, проектирование, извлечение смысла, объяснение, обучение и т.п.);

Наличие моделей мышления на основе баз знаний: правил и логических выводов, аргументации и рассуждения, распознавания и классификации ситуаций, обобщения и понимания и т.п.;

Способность формировать вполне четкие решения на основе нечетких, нестрогих, неполных, недоопределенных данных;

Способность объяснять выводы и решения, т.е. наличие механизма объяснений;

Способность к обучению, переобучению и, следовательно, к развитию.

Технологии неформализованного поиска скрытых закономерностей в данных и информации Knowledge Discovery (KD) базируются на новейших технологиях формирования и структурирования информационных образов объектов, что ближе всего лежит к принципам обработки информации интеллектуальными системами.

Информационные технологии поддержки процесса принятия решений Decision Support (DS) представляют собой оболочки эксперт-

ных систем или специализированные экспертные системы, которые предоставляют возможность аналитикам определять отношения и взаимосвязи между информационными структурами в базах структурированной информации предприятия, а также прогнозировать возможные результаты принятия решений.

Тенденции развития ИИТ. Системы связи и коммуникаций. Глобальные информационные сети и ИИТ могут в корне поменять наши представления о компаниях и самом умственном труде. Присутствие сотрудников на рабочем месте станет практически не нужным. Люди могут работать дома и взаимодействовать друг с другом при необходимости через сети. Известен, например, успешный опыт создания новой модификации самолета «Боинг-747» распределенным коллективом специалистов, взаимодействующих по Интернет. Местонахождение участников каких-либо разработок будет играть все меньшую роль, зато возрастает значение уровня квалификации участников. Другая причина, определившая бурное развитие ИИТ, связана с усложнением систем коммуникации и решаемых на их основе задач. Потребовался качественно новый уровень «интеллектуализации» таких программных продуктов, как системы анализа разнородных и нестрогих данных, обеспечения информационной безопасности, выработки решений в распределенных системах и т.п.

Образование . Уже сегодня дистанционное обучение начинает играть важную роль в образовании, а внедрение ИИТ позволит существенно индивидуализировать этот процесс сообразно с потребностями и способностями каждого обучаемого.

Быт . Информатизация быта уже началась, но с развитием ИИТ появятся принципиально новые возможности. Постепенно компьютеру будут передаваться все новые функции: контроль над состоянием здоровья пользователя, управление бытовыми приборами, такими как увлажнители, освежители воздуха, обогреватели, ионизаторы, музыкальные центры, средства медицинской диагностики и т.п. Другими словами, системы станут еще и диагностами состояния человека и его жилища. Будет обеспечено комфортное информационное пространство в помещениях, где информационная среда станет частью окружающей человека среды.

Перспективы развития ИИТ . Представляется, что в настоящее время ИИТ подошли к принципиально новому этапу своего развития. Так, за последние 10 лет существенно расширились возможности ИИТ за счет разработки новых типов логических моделей, появления но-

вых теорий и представлений. Узловыми точками в развитии ИИТ считаются:

Переход от логического вывода к моделям аргументации и рассуждения;

Поиск релевантных знаний и порождение объяснений;

Понимание и синтез текстов;

Когнитивная графика, т.е. графическое и образное представление знаний;

Мультиагентные системы;

Интеллектуальные сетевые модели;

Вычисления, основанные на нечеткой логике, нейронных сетях, генетических алгоритмах, вероятностных вычислениях (реализуемых в различных комбинациях друг с другом и с экспертными системами);

Проблема метазнаний.

Новой парадигмой создания перспективных ИИТ стали мультиагентные системы. Здесь предполагается, что агент - это самостоятельная интеллектуальная система, имеющая свою систему целеполагания и мотивации, свою область действий и ответственности. Взаимодействие между агентами обеспечивается системой более высокого уровня - метаинтеллектом. В мультиагентных системах моделируется виртуальное сообщество интеллектуальных агентов - объектов, которые автономны, активны, вступают в различные социальные отношения - кооперации и сотрудничества (дружбы), конкуренции, соревнования, вражды и т.п. Социальный аспект решения современных задач и есть фундаментальная особенность концептуальной новизны передовых интеллектуальных технологий - виртуальных организаций, виртуального общества.

(?) Контрольные вопросы и задания

1. Дайте характеристику предприятия как объекта информатизации. Назовите основные показатели, характеризующие развитие системы управления предприятием.

2. Перечислите ведущие информационные технологии управления промышленным предприятием.

3. Назовите основные информационные технологии организационного и стратегического развития предприятий (корпорации).

4. Каковы основы стандартов стратегического управления, направленного на улучшение бизнес-процессов? Каково соотношение информационных технологий ВРМ и BPI?

5. Дайте определение философии всеобщего управления качеством (TQM). Как связаны фазы развития качества и информационные технологии?

6. Назовите основные положения организационного развития предприятия, охарактеризуйте этапы стратегического управления. Назовите групповые стратегии.

7. Как создается бизнес-модель предприятия? Назовите основные подходы к оценке эффективности бизнес-модели.

8. Что такое система сбалансированных показателей? Назовите основные составляющие ССП. Каковы взаимосвязи групп показателей ССП?

9. Перечислите методические основы создания информационных систем. Что такое системный подход?

10. Что такое информационный подход к формированию информационных систем и технологий?

11. Что такое стратегический подход к формированию информационных систем и технологий?

12. Каково содержание объектно-ориентированного подхода к описанию поведения агентов на рынке? Дайте определение объекта, укажите аналоги агентных систем.

13. Каковы методические принципы совершенствования управления предприятием на основе информационно-коммуникационных технологий? Каково целевое назначение ИКТ?

14. Дайте определения документа, документопотока, документооборота, системы документационного управления.

15. Как проектируется макет формы документа? Назовите зоны документа, состав их реквизитов.

16. Назовите базовые информационные технологии системы документационного управления.

17. Что такое унифицированная система документации? Каковы общие принципы унификации?

18. Дайте характеристику организационно-распорядительной документации, приведите примеры документов.

19. Каким требованиям должна удовлетворять электронная система управления документооборотом?

20. Что такое корпоративная информационная система? Назовите основные контуры управления, состав функциональных модулей.

21. Назовите известные вам программные продукты для КИС. Дайте их сравнительную характеристику.

Ш Литература

1. Вернет Дж., Мориарти С. Маркетинговые коммуникации. Интегрированный подход. СПб.; Харьков: Питер, 2001.

2. Брукинг Э. Интеллектуальный капитал. Ключ к успеху в новом тысячелетии. СПб.: Питер, 2001.

3. Годин В.В., Корпев И.К. Управление информационными ресурсами. М.: ИНФРА-М, 1999.

4. Информационные системы и технологии в экономике: Учебник. 2-е изд., доп. и перераб. / М.И. Семенов, И.Т. Трубилин, В.И. Лойко, Т.П. Барановская; Под ред. В.И. Лойко. М.: Финансы и статистика, 2003.

5. Информационные технологии в бизнесе / Под ред. М. Желены. СПб.: Питер, 2002.

6. Каплан Роберт С., Нортон Дейвид П. Сбалансированная система показателей. От стратегии к действию / Пер. с англ. М.: ЗАО «Олимп-Бизнес», 2003.

7. Карагодин В.И., Карагодина BJI. Информация как основа жизни. Дубна: Феникс, 2000.

8. Карминский AM., Нестеров ПЗ. Информатизация бизнеса. М.: Финансы и статистика, 1997.

9. Лихачева Т.Н. Информационные технологии на службе информационного общества // Новые информационные технологии в экономических системах. М., 1999.

10. Острейковский В.А. Теория систем. М.: Высшая школа, 1997.

11. Питеркин С.В., Оладов Н.А., Исаев Д.В. Точно вовремя для России. Практика применения ERP-систем. 2-е изд. М.: Альпина Паблишер, 2003.

12. Соколов Д.В. Введение в теорию социальной коммуникации: Учеб. пособие. СПб.: Изд-во СП6ГУП, 1996.

13. Трофимов В.З., Томилов В.З. Информационно-коммуникационные технологии в менеджменте: Учеб. пособие. СПб.: Изд-во СПбГУЭФ, 2002.

Введение

Настоящий дипломный проект продолжает работу по развитию автоматизированной информационно-поисковой системы "Международное научно-техническое сотрудничество вузов России", разработанной в рамках научно-исследовательской работы с Министерством образования и науки Российской Федерации (Минобрнауки). На данном этапе одной из главных задач является поиск новых решений, позволяющих выполнять оперативную аналитическую обработку информации с учетом больших объемов данных, сложности связей между ними, ограниченности времени пользователя.

Дипломный проект посвящен разработке многомерных моделей данных для построения OLAP-кубов, созданию программного механизма доступа к этим данным, разработке web-интерфейса пользователя, позволяющего формировать структуры выводимых данных в зависимости от потребностей оператора, осуществлять визуализацию полученных результатов.

Разработанное приложение является актуальным инструментом для обеспечения организационной деятельности соответствующих подразделений Федерального агентства по образованию как в ежедневной практической работе (оперативная подготовка текущих справок и рабочих материалов по тем или иным проблемам международного научно-технического сотрудничества, статистических данных к совещаниям, заседаниям и т.д.), так и при подведении итогов (ежемесячные, квартальные, годовые и прочие отчеты). Функционал приложения может пригодиться в области статистики и аналитики.

Решение использовать формат web-приложения позволяет получать доступ к базе данных из любой точки мира, пропадает необходимость в установке дополнительного клиентского программного обеспечения.

Обзор и анализ программных технологий разработки WEB-приложений для аналитической обработки данных

Технологии оперативной аналитической обработки данных

программный модель приложение данные

В настоящее время огромные объемы данных накапливаются в учетных, так называемых транзакционных (OLTP), системах.

Такие системы строятся на основе современных СУБД, в которых развит механизм управления транзакциями, что сделало их основным средством создания систем оперативной обработки транзакций (OLTP-систем, On-Line Transactions Processing).

Основной задачей таких систем является обеспечение выполнения операций с БД. В таких системах почти всегда предусмотрены и поисковые функции, в том числе позволяющие выводить некоторую итоговую и агрегированную информацию.

Но возможности таких систем для выполнения комплексного, углубленного анализа данных, позволяющего принимать обоснованные решения, ограничены.

Без продуктивной переработки и анализа колоссальные потоки информационной руды, т.е. сырые данные, образуют никому не нужную свалку.

В связи с этим возникла необходимость создания аналитических систем, которые бы позволяли превратить сырые данные в полезные информацию и знания, на основе которых можно принимать управленческие решения.

Анализ данных в той или иной степени проводится во многих информационных системах, в том числе и в OLTP-системах. Но виды анализа данных различаются в зависимости от гибкости и глубины проводимого анализа.

Информационно-поисковый анализ - анализ данных, проводимый по заранее определенным, т.е. заранее заданным видам запросов (регламентированным запросам).

Оперативно-аналитический анализ - анализ данных, который требует формирования нерегламентированных запросов, когда невозможно заранее предсказать, какие запросы понадобятся пользователю.

Интеллектуальный анализ - глубокий анализ данных, позволяющий получать из имеющихся данных скрытые для пользователя знания, такие как:

§ функциональные и логические закономерности в накопленных данных;

§ модели и правила, объясняющие найденные закономерности;

§ прогнозы развития процессов.

Сравнение характеристик различных видов анализа данных иллюстрирует таблица 1.1.

|

Характеристики |

Виды анализа данных |

||

|

Информационно-поисковый анализ |

Оперативно-аналитический анализ |

Интеллектуальный анализ |

|

|

Виды запросов |

Регламентированные |

Нерегламентированные |

Глубокий анализ |

|

Вид получаемых данных |

Выборки сырых данных |

Обобщенная, сгруппированная, агрегированная информация |

Модели, шаблоны, закономерности, знания |

|

Решаемые задачи |

Получение выборок данных |

Грубый разведочный анализ, проверка заранее сформулированных гипотез |

Получение новых, нетривиальных, скрытых знаний |

|

Уровень интерактивности |

Интерактивное взаимодействие с информацией |

Таблица 1.1 - Сравнение видов анализа данных

В соответствии с рассмотренными выше видами анализа данных аналитические системы можно разделить на следующие группы:

1. Системы корпоративной отчетности:

§ используются для контроля оперативной ситуации и анализа отклонений (отвечают на вопрос «что происходит»);

§ предоставляют оперативные данные о результатах деятельности в виде заранее заданных форм отчетности;

§ базируются на информационно-поисковом анализе данных;

§ могут не использовать хранилище данных, а брать данные непосредственно из OLTP-систем;

§ предназначены для широкого круга конечных пользователей (клиенты, партнеры, фискальные учреждения).

2. Системы аналитической обработки данных и аналитической отчетности (OLAP-системы - системы оперативной аналитической обработки, On-Line Analytical Processing):

§ позволяют выполнять многомерный анализ данных по различным срезам;

§ обладают развитыми средствами аналитической отчетности и визуализации данных в виде различных типов таблиц, графиков и диаграмм;

§ базируются на оперативно-аналитическом анализе данных;

§ чаще всего используют хранилище данных, оптимизированное под задачи многомерного анализа данных;

§ ориентированы на пользователей, которым требуется постоянное интерактивное взаимодействие с информацией (менеджеры, аналитики).

3. Системы глубокого анализа данных:

§ обладают развитыми инструментами для проведения глубокого анализа;

§ позволяют получить нетривиальные, скрытые знания;

§ используют хранилище данных в качестве источника информации;

§ базируются на интеллектуальном анализе данных;

§ предназначены для аналитиков, обладающих знаниями в области методов анализа данных;

§ позволяют создавать законченные приложения для конечных пользователей в виде построенных моделей, шаблонов и отчетов.

Схематичное описание разделения аналитических систем по вышепредставленным группам отображено на рисунке 1.1.1.

OLAP (On-Line Analytical Processing) - технология оперативной аналитической обработки данных, использующая методы и средства сбора, хранения и анализа многомерных данных, в целях поддержки аналитической деятельности и возможности формирования нерегламентированных запросов и отчетов на их основе.

Рисунок 1.1.1 - Виды аналитических систем

OLAP-системы создаются для конечных пользователей и аналитиков, предоставляя им инструменты для анализа данных и проверки возникающих гипотез.

Известен тест, созданный в 1995 году, определяющий критерии, по которым систему можно отнести к классу OLAP-систем.

Этот тест получил название FASMI (Fast Analysis of Shared Multidimensional Information) (быстрый анализ совместно используемой многомерной информации) и в настоящее время широко используется.

В соответствии с тестом FASMI OLAP определяется пятью ключевыми словами:

§ Fast (Быстрый);

§ Analysis (Анализ);

§ Shared (Разделяемой);

§ Multidimensional (Многомерной);

§ Information (Информации).

Схематичное представление теста изображено на рисунке 1.1.2.

Рисунок 1.1.2 - Тест FASMI.

1. Fast (Быстрый)

OLAP-система должна обеспечить выдачу ответов на большинство запросов в пределах приблизительно 5 секунд. Для простых запросов этот показатель может быть 1 секунда, а для редкостных по сложности запросов он может достигать 20 секунд.

Исследования показывают, что если отклик не получен в течение 30 секунд, то пользователь перестает считать систему полезной. Он способен нажать комбинацию клавиш , если система не предупредит, что обработка данных требует большего времени.

Но даже если система предупредит пользователя о продолжительном времени обработки аналитического запроса, пользователь может отвлечься и потерять мысль, что негативно скажется на качестве анализа.

Такой скорости обработки нелегко достигнуть на огромных массивах данных, особенно если требуются нестандартные и сложные запросы, формируемые «на лету».

Для достижения данной цели разработчики OLAP-систем используют разные методы:

Динамическая предобработка данных;

Создание специальных программно-аппаратных решений;

Применение аппаратных платформ с большей производительностью.

Критерий скорости является наиболее критическим в определении принадлежности системы к классу OLAP.

2. Analysis (Анализ).

OLAP-система должна справляться с любым логическим и статистическим анализом, характерным для данной прикладной области.

Все требуемые функциональные возможности анализа должны обеспечиваться понятным для пользователя способом.

OLAP-система должна обладать гибкостью в выдаче графических результатов анализа и позволять формировать отчеты любым желаемым способом без необходимости программирования.

3. Shared (Разделяемой).

OLAP-система должна работать в многопользовательском режиме, в связи с чем особо встает вопрос обеспечения конфиденциальности информации и наличия в таких системах средств защиты информации (права доступа, авторизация доступа и т.д.).

4. Multidimensional (Многомерной).

OLAP-система должна обеспечивать многомерное представление данных. Речь не идет о числе измерений многомерной модели данных или размерах каждого измерения. Это зависит от конкретной прикладной области и решаемых аналитических задач.

5. Information (Информации).

OLAP-система должна обеспечивать получение необходимой информации в условиях реального приложения.

Мощность OLAP-системы определяется количеством входных данных, которые она может обработать. Способности OLAP-систем к обработке информации разнятся в 1000 раз, что определяется множеством факторов, включая требуемую оперативную память, использование дискового пространства, интеграцию с хранилищами данных и другими аналитическими компонентами.

Таким образом, в тесте FASMI сделан акцент на такие важные свойства OLAP-систем как скорость обработки, многопользовательский доступ, релевантность информации, наличие средств статистического анализа и многомерность, т.е. представление анализируемых фактов как функций от большого числа их характеризующих параметров.

3.4 Способы аналитической обработки данных

Для того чтобы существующие хранилища данных способствовали принятию управленческих решений, информация должна быть представлена аналитику в нужной форме, т. е. он должен иметь развитые инструменты доступа к данным хранилища и их обработки.

Очень часто информационно-аналитические системы, создаваемые в расчете на непосредственное использование лицами, принимающими решения, оказываются чрезвычайно просты в применении, но жестко ограничены в функциональности. Такие статические системы называются Информационными системами руководителя (ИСР), или Executive Information Systems (EIS). Они содержат в себе множества запросов и, будучи достаточными для повседневного обзора, неспособны ответить на все вопросы которые могут возникнуть при принятии решений. Результатом работы такой системы, как правило, являются многостраничные отчеты, после тщательного изучения, которых у аналитика появляется новая серия вопросов. Однако каждый новый запрос, непредусмотренный при проектировании такой системы, должен быть сначала формально описан, закодирован программистом и только затем выполнен. Время ожидания в таком случае может составлять часы и дни, что не всегда приемлемо.

Оперативная аналитическая обработка . Или On-Line Analytical Processing, OLAP – это ключевой компонент организации хранилищ данных. Концепция OLAP была описана в 1993 г. Эдгаром Коддом и имеет следующие требования к приложениям для многомерного анализа:

– многомерное концептуальное представление данных, включая полную поддержку для иерархий и множественных иерархий (ключевое требование OLAP);

– предоставление пользователю результатов анализа за приемлемое время (обычно не более 5 с), пусть даже ценой менее детального анализа;

– возможность осуществления любого логического и статистического анализа, характерного для данного приложения, и его сохранения в доступном для конечного пользователя виде;

– многопользовательский доступ к данным с поддержкой соответствующих механизмов блокировок и средств авторизованного доступа;

– возможность обращаться к любой нужной информации независимо от ее объема и места хранения.

OLAP-система состоит из множества компонент. На самом высоком уровне представления система включает в себя источник данных, многомерную базу данных (МБД), предоставляющая возможность реализации механизма составления отчетов на основе технологии OLAP, OLAP-сервер и клиента. Система построена по принципу клиент-сервер и обеспечивает удаленный и многопользовательский доступ к серверу МБД.

Рассмотрим составные части OLAP-системы.

Источники. Источником в OLAP-системах является сервер, поставляющий данные для анализа. В зависимости от области использования OLAP-продукта источником может служить хранилище данных, наследуемая база данных, содержащая общие данные, набор

таблиц, объединяющих финансовые данные или любая комбинация перечисленного.

Хранилище данных . Исходные данные собираются и помещаются в хранилище, спроектированное в соответствии с принципами построения хранилищ данных. ХД представляет из себя реляционную базу данных (РБД). Основная таблица ХД (таблица фактов) содержит числовые значения показателей, по которым собирается статистическая информация.

Многомерная база данных .Хранилище данных служит поставщиком информации для многомерной базы данных, которая является набором объектов. Основными классами этих объектов являются измерения и показатели. К измерениям относятся множества значений (параметров), по которым происходит индексация данных, например, время, регионы, тип учреждения и пр. Каждое измерение заполняется значениями из соответствующих таблиц измерений хранилища данных. Совокупность измерений определяет пространство исследуемого процесса. Под показателями понимаются многомерные кубы данных (гиперкубы). В гиперкубе содержатся сами данные, а также агрегатные суммы по измерениям, входящим в состав показателя. Показатели составляют основное содержание МБД и заполняются в соответствии с таблицей фактов. Вдоль каждой оси гиперкуба данные могут быть организованы в виде иерархии, представляющей различные уровни их детализации. Это позволяет создавать иерархические измерения, по которым при последующем анализе данных будут осуществляться агрегирование или детализация представления данных. Типичным примером иерархического измерения служит список территориальных объектов сгруппированных по районам, областям, округам.

Сервер. Прикладной частью OLAP-системы является OLAP-сервер. Эта составляющая выполняет всю работу (в зависимости от модели системы), и хранит в себе всю информацию, к которой обеспечивается активный доступ. Архитектурой сервера управляют различные концепции. В частности, основной функциональной характеристикой OLAP-продуктов является использование МБД либо РБД для хранения данных.

Клиентское приложение .Данные, структурированные соответствующим образом и хранимые в МБД доступны для анализа с помощью клиентского приложения. Пользователь получает возможность удаленного доступа к данным, формулирования сложных запросов, генерации отчетов, получения произвольных подмножеств данных. Получение отчета сводится к выбору конкретных значений измерений и построению сечения гиперкуба. Сечение определяется выбранными значениями измерений. Данные по остальным измерениям суммируются.

OLAP на клиенте и на сервере. Многомерный анализ данных может быть проведен с помощью различных средств, которые условно можно разделить на клиентские и серверные OLAP-средства.

Клиентские OLAP-средства (например, Pivot Tables в Excel 2000 фирмы Microsoft или ProClarity фирмы Knosys) представляют собой приложения, осуществляющие вычисление агрегатных данных и их отображение. При этом сами агрегатные данные содержатся в кэше внутри адресного пространства такого OLAP-средства.

Если исходные данные содержатся в настольной СУБД, вычисление агрегатных данных производится самим OLAP-средством. Если же источник исходных данных – серверная СУБД, многие из клиентских OLAP-средств посылают на сервер SQL-запросы и в результате получают агрегатные данные, вычисленные на сервере.

Как правило, OLAP-функциональность реализована в средствах статистической обработки данных и в некоторых электронных таблицах.

Многие средства разработки содержат библиотеки классов или компонентов, позволяющие создавать приложения, реализующие простейшую OLAP-функциональность (такие, например, как компоненты Decision Cube в Borland Delphi и Borland C++ Builder). Помимо этого многие компании предлагают элементы управления ActiveX и другие библиотеки, реализующие подобную функциональность.

Клиентские OLAP-средства применяются, как правило, при малом числе измерений (обычно не более шести) и небольшом разнообразии значений этих параметров – поскольку полученные агрегатные данные должны умещаться в адресном пространстве подобного средства, а их количество растет экспоненциально при увеличении числа измерений.

Многие клиентские OLAP-средства позволяют сохранить содержимое кэша с агрегатными данными в виде файла, для того чтобы не производить их повторное вычисление. Однако нередко такая возможность используется для отчуждения агрегатных данных с целью передачи их другим организациям или для публикации.

Идея сохранения кэша с агрегатными данными в файле получила свое дальнейшее развитие в серверных OLAP-средствах (например, Oracle Express Server или Microsoft OLAP Services), в которых сохранение и изменение агрегатных данных, а также поддержка содержащего их хранилища осуществляются отдельным приложением или процессом, называемым OLAP-сервером. Клиентские приложения могут запрашивать подобное многомерное хранилище и в ответ получать те или иные данные. Некоторые клиентские приложения могут также создавать такие хранилища или обновлять их в соответствии с изменившимися исходными данными.

Преимущества применения серверных OLAP-средств по сравнению с клиентскими OLAP-средствами сходны с преимуществами применения серверных СУБД по сравнению с настольными: в случае применения серверных средств вычисление и хранение агрегатных данных происходят на сервере, а клиентское приложение получает лишь результаты запросов к ним, что позволяет в общем случае снизить сетевой трафик, время выполнения запросов и требования к ресурсам, потребляемым клиентским приложением.

3.5 Технические аспекты многомерного хранения данных

Многомерность в OLAP-приложениях может быть разделена на три уровня:

1. Многомерное представление данных – средства конечного пользователя, обеспечивающие многомерную визуализацию и манипулирование данными; слой многомерного представления абстрагирован от физической структуры данных и воспринимает данные как многомерные.

Многомерная обработка – средство (язык) формулирования многомерных запросов (традиционный реляционный язык SQL здесь оказывается непригодным) и процессор, умеющий обработать и выполнить такой запрос.

Многомерное хранение – средства физической организации данных, обеспечивающие эффективное выполнение многомерных запросов.

Первые два уровня в обязательном порядке присутствуют во всех OLAP-средствах. Третий уровень, хотя и является широко распространенным, не обязателен, так как данные для многомерного представления могут извлекаться и из обычных реляционных структур. Процессор многомерных запросов, в этом случае, транслирует многомерные запросы в SQL-запросы, которые выполняются реляционной СУБД.

В любом хранилище данных – и в обычном, и в многомерном – наряду с детальными данными, извлекаемыми из оперативных систем, хранятся и агрегированные показатели (суммарные показатели), такие, как суммы объемов продаж по месяцам, по категориям товаров и т. д. Агрегаты хранятся в явном виде с единственной целью – ускорить выполнение запросов. Ведь, с одной стороны, в хранилище накапливается, как правило, очень большой объем данных, а с другой – аналитиков в большинстве случаев интересуют не детальные, а обобщенные показатели. И если каждый раз для вычисления суммы продаж за год пришлось бы суммировать миллионы индивидуальных продаж, скорость, скорее всего, была бы неприемлемой. Поэтому при загрузке данных в многомерную БД вычисляются и сохраняются все суммарные показатели или их часть.

Тем не менее, использование агрегированных данных чревато недостатками. Основными недостатками являются увеличение объема хранимой информации (при добавлении новых измерений объем данных, составляющих куб, растет экспоненциально) и времени на их загрузку. Причем объем информации может увеличиваться в десятки и даже в сотни раз. Например, в одном из опубликованных стандартных тестов полный подсчет агрегатов для 10 Мб исходных данных потребовал 2,4 Гб, т. е. данные выросли в 240 раз!

Степень увеличения объема данных при вычислении агрегатов зависит от количества измерений куба и структуры этих измерений, т. е. соотношения количества «родителей» и «потомков» на разных уровнях измерения. Для решения проблемы хранения агрегатов применяются сложные схемы, позволяющие при вычислении далеко не всех возможных агрегатов достигать значительного повышения производительности выполнения запросов.

Как исходные, так и агрегатные данные могут храниться либо в

реляционных, либо в многомерных структурах. В связи с этим в настоящее время применяются три способа хранения многомерных данных:

MOLAP (Multidimensional OLAP) – исходные и агрегатные данные хранятся в многомерной базе данных. Хранение данных в многомерных структурах позволяет манипулировать данными как многомерным массивом, благодаря чему скорость вычисления агрегатных значений одинакова для любого из измерений. Однако в этом случае многомерная база данных оказывается избыточной, так как многомерные данные полностью содержат исходные реляционные данные.

Эти системы обеспечивают полный цикл OLAP-обработки. Они либо включают в себя, помимо серверного компонента, собственный интегрированный клиентский интерфейс, либо используют для связи с пользователем внешние программы работы с электронными таблицами.

ROLAP (Relational OLAP) – исходные данные остаются в той же реляционной базе данных, где они изначально и находились. Агрегатные же данные помещают в специально созданные для их хранения служебные таблицы в той же базе данных.

HOLAP (Hybrid OLAP) – исходные данные остаются в той же реляционной базе данных, где они изначально находились, а агрегатные данные хранятся в многомерной базе данных.

Некоторые OLAP-средства поддерживают хранение данных только в реляционных структурах, некоторые – только в многомерных. Однако большинство современных серверных OLAP-средств поддерживают все три способа хранения данных. Выбор способа хранения зависит от объема и структуры исходных данных, требований к скорости выполнения запросов и частоты обновления OLAP-кубов.

3.6 Интеллектуальный анализ данных (Data Mining )

Термин Data Mining обозначает процесс поиска корреляций, тенденций и взаимосвязей посредством различных математических и статистических алгоритмов: кластеризации, регрессионного и корреляционного анализа и т. д. для систем поддержки принятия решений. При этом накопленные сведения автоматически обобщаются до информации, которая может быть охарактеризована как знания.

В основу современной технологии Data Mining положена концепция шаблонов, отражающих закономерности, свойственные подвыборкам данных и составляющие так называемые скрытые знания.

Поиск шаблонов производится методами, не использующими никаких априорных предположений об этих подвыборках. Важной особенностью Data Mining является нестандартность и неочевидность разыскиваемых шаблонов. Иными словами, средства Data Mining отличаются от инструментов статистической обработки данных и средств OLAP тем, что вместо проверки заранее предполагаемых пользователями взаимосвязей

между данными, они на основании имеющихся данных способны самостоятельно находить такие взаимосвязи, а также строить гипотезы об их характере.

В общем случае процесс интеллектуального анализа данных (Data Mining) состоит из трёх стадий

выявление закономерностей (свободный поиск);

использование выявленных закономерностей для предсказания неизвестных значений (прогностическое моделирование);

анализ исключений, предназначенный для выявления и толкования аномалий в найденных закономерностях.

Иногда в явном виде выделяют промежуточную стадию проверки достоверности найденных закономерностей между их нахождением и использованием (стадия валидации).

Выделяют пять стандартных типов закономерностей, выявляемых методами Data Mining:

1.Ассоциация позволяет выделить устойчивые группы объектов, между которыми существуют неявно заданные связи. Частота появления отдельного предмета или группы предметов, выраженная в процентах, называется распространенностью. Низкий уровень распространенности (менее одной тысячной процента) говорит о том, что такая ассоциация не существенна. Ассоциации записываются в виде правил: A => B , где А - посылка, В - следствие. Для определения важности каждого полученного ассоциативного правила необходимо вычислить величину, которую называют доверительность А к В (или взаимосвязь А и В). Доверительность показывает, как часто при появлении А появляется В. Например, если д(A/B) =20%, то это значит, что при покупке товара А в каждом пятом случае приобретается и товар В.

Типичным примером применения ассоциации является анализ структуры покупок. Например, при проведении исследования в супермаркете можно установить, что 65 % купивших картофельные чипсы берут также и «кока-колу», а при наличии скидки за такой комплект «колу» приобретают в 85 % случаев. Подобные результаты представляют ценность при формировании маркетинговых стратегий.

2.Последовательность - это метод выявления ассоциаций во времени. В данном случае определяются правила, которые описывают последовательное появление определенных групп событий. Такие правила необходимы для построения сценариев. Кроме того, их можно использовать, например, для формирования типичного набора предшествующих продаж, которые могут повлечь за собой последующие продажи конкретного товара.

3.Классификация - инструмент обобщения. Она позволяет перейти от рассмотрения единичных объектов к обобщенным понятиям, которые характеризуют некоторые совокупности объектов и являются достаточными для распознавания объектов, принадлежащих этим совокупностям (классам). Суть процесса формирования понятий заключается в нахождении закономерностей, свойственных классам. Для описания объектов используются множества различных признаков (атрибутов). Проблема формирования понятий по признаковым описаниям была сформулирована М.М. Бонгартом. Ее решение базируется на применении двух основных процедур: обучения и проверки. В процедурах обучения строится классифицирующее правило на основе обработки обучающего множества объектов. Процедура проверки (экзамена) состоит в использовании полученного классифицирующего правила для распознавания объектов из новой (экзаменационной) выборки. Если результаты проверки признаны удовлетворительными, то процесс обучения заканчивается, в противном случае классифицирующее правило уточняется в процессе повторного обучения.

4.Кластеризация – это распределение информации (записей) из БД по группам (кластерам) или сегментам с одновременным определением этих групп. В отличие от классификации здесь для проведения анализа не требуется предварительного задания классов.

5.Прогнозирование временных рядов является инструментом для определения тенденций изменения атрибутов рассматриваемых объектов с течением времени. Анализ поведения временных рядов позволяет прогнозировать значения исследуемых характеристик.

Для решения таких задач используются различные методы и алгоритмы Data Mining. Ввиду того, что Data Mining развивалась и развивается на стыке таких дисциплин, как статистика, теория информации, машинное обучение, теория баз данных, вполне закономерно, что большинство алгоритмов и методов Data Mining были разработаны на основе различных методов из этих дисциплин.

Из многообразия существующих методов исследования данных можно выделить следующие:

регрессионный, дисперсионный и корреляционный анализ (реализован в большинстве современных статистических пакетов, в частности, в продуктах компаний SAS Institute, StatSoft и др.);

методы анализа в конкретной предметной области, базирующиеся на эмпирических моделях (часто применяются, например, в недорогих средствах финансового анализа);

нейросетевые алгоритмы – метод имитации процессов и явлений, позволяющий воспроизводить сложные зависимости. Метод основан на использовании упрощенной модели биологического мозга и заключается в том, что исходные параметры рассматриваются как сигналы, преобразующиеся в соответствии с имеющимися связями между «нейронами», а в качестве ответа, являющегося результатом анализа, рассматривается отклик всей сети на исходные данные. Связи в этом случае создаются с помощью так называемого обучения сети посредством выборки большого объема, содержащей как исходные данные, так и правильные ответы. Нейронные сети широко применяются для решения задач классификации;

нечеткая логика применяется для обработки данных с размытыми значениями истинности, которые могут быть представлены разнообразными лингвистическими переменными. Нечеткое представление знаний широко применяется для решения задач классификации и прогнозирования, например, в системе XpertRule Miner (Attar Software Ltd., Великобритания), а также в AIS, NeuFuz и др;

индуктивные выводы позволяют получить обобщения фактов, хранящихся в БД. В процессе индуктивного обучения может участвовать специалист, поставляющий гипотезы. Такой способ называют обучением с учителем. Поиск правил обобщения может осуществляться без учителя путем автоматической генерации гипотез. В современных программных средствах, как правило, сочетаются оба способа, а для проверки гипотез используются статистические методы. Примером системы с применением индуктивных выводов является XpertRule Miner, разработанная фирмой Attar Software Ltd. (Великобритания);

рассуждения на основе аналогичных случаев (метод «ближайшего соседа») (Case-based reasoning – CBR) основаны на поиске в БД ситуаций, описания которых сходны по ряду признаков с заданной ситуацией. Принцип аналогии позволяет предполагать, что результаты похожих ситуаций также будут близки между собой. Недостаток этого подхода заключается в том, что здесь не создается каких-либо моделей или правил, обобщающих предыдущий опыт. Кроме того, надежность выводимых результатов зависит от полноты описания ситуаций, как и в процессах индуктивного вывода. Примерами систем, использующих CBR, являются: KATE Tools (Acknosoft, Франция), Pattern Recognition Workbench (Unica, США);

деревья решений – метод структурирования задачи в виде древовидного графа, вершины которого соответствуют продукционным правилам, позволяющим классифицировать данные или осуществлять анализ последствий решений. Этот метод дает наглядное представление о системе классифицирующих правил, если их не очень много. Простые задачи решаются с помощью этого метода гораздо быстрее, чем с использованием нейронных сетей. Для сложных проблем и для некоторых типов данных деревья решений могут оказаться неприемлемыми. Кроме того, для этого метода характерна проблема значимости. Одним из последствий иерархической кластеризации данных является отсутствие большого числа обучающих примеров для многих частных случаев, в связи с чем классификацию нельзя считать надежной. Методы деревьев решений реализованы во многих программных средствах, а именно: С5.0 (RuleQuest, Австралия), Clementine (Integral Solutions, Великобритания), SIPINA (University of Lyon, Франция), IDIS (Information Discovery, США);

эволюционное программирование – поиск и генерация алгоритма, выражающего взаимозависимость данных, на основании изначально заданного алгоритма, модифицируемого в процессе поиска; иногда поиск взаимозависимостей осуществляется среди каких-либо определенных видов функций (например, полиномов);

алгоритмы ограниченного перебора , вычисляющие комбинаций простых логических событий в подгруппах данных.

3.7 Интеграция OLAP и Data Mining

Оперативная аналитическая обработка (OLAP) и интеллектуальный анализ данных (Data Mining) – две составные части процесса поддержки принятия решений. Однако сегодня большинство систем OLAP заостряет внимание только на обеспечении доступа к многомерным данным, а большинство средств Data Mining, работающих в сфере закономерностей, имеют дело с одномерными перспективами данных. Для увеличения эффективности обработки данных для систем поддержки принятия решений эти два вида анализа должны быть объединены.

В настоящее время появляется составной термин «OLAP Data Mining» (многомерный интеллектуальный анализ) для обозначения такого объединения.

Существует три основных способа формирования «OLAP Data Mining»:

- Учебно-методическое пособие

... лекций . Подготовка лекции по математике. Написание конспекта лекции лекции . Использование информационных технологий ...

И к кондаурова с в лебедева научно-исследовательская деятельность будущего учителя математики творческие задания по элементарной математике и методике её преподавания

Учебно-методическое пособие... лекций . Подготовка лекции по математике. Написание конспекта лекции . Подготовка наглядных пособий. Методика чтения лекции . Использование информационных технологий ...

М ОНИТОРИНГ СМИ Модернизация профессионального образования Март - август 2011г

Краткое содержание... 11 .08.2011 "Мертвые души-2" В РНИМУ им ... 3,11 -3,44 . ... публичные лекции руководителей... Чебоксарах ... и строчащая конспекты аудитория - ... информационные системы и технологии . ... системой образования, - говорит доцент ... составителей ... части повышения реального содержания ...

«Cubing then mining». Возможность выполнения интеллектуального анализа должна обеспечиваться над любым результатом запроса к многомерному концептуальному представлению, то есть над любым фрагментом любой проекции гиперкуба показателей.

«Mining then cubing». Подобно данным, извлечённым из хранилища, результаты интеллектуального анализа должны представляться в гиперкубической форме для последующего многомерного анализа.

«Cubing while mining». Этот гибкий способ интеграции позволяет автоматически активизировать однотипные механизмы интеллектуальной обработки над результатом каждого шага многомерного анализа (перехода) между уровнями обобщения, извлечения нового фрагмента гиперкуба и т. д.).

Астрономия для 11 класса [Текст... им как часть всей системы ... доцент ... Чебоксары , 2009. № 10. С. 44 -49 ... . Авторы-составители : Н. ... конспекты лекций , ...

Галина Акимова, Матвей Пашкин

Технология обработки информации из различных источников, в том числе и из Интернет-СМИ, обеспечивает автоматизированный ввод (включающий тематический анализ текста, обработку, хранение и поиск) и получение статистических сводок и дайджестов.

На сегодняшний день основным методом аналитической обработки текстовых массивов данных остается поиск документов по ключевым словам. Интеллектуальность этой операции повышается за счет автоматического ранжирования найденных документов с использованием достаточно простых методов определения их значимости, учета морфологии языка и (гораздо реже) семантических словарей.

Однако для решения современных аналитических задач, особенно учитывая огромный объем исходной информации (в первую очередь из Интернета), этого явно недостаточно. В качестве примера того, что нужно сегодня заказчикам, можно привести разработанную в Колумбийском университете программу Newsblaster. Первоначально она предназначалась для упрощения поиска информации в Web, но на самом деле она в состоянии извлекать из Интернета любые важные новости. Эта система просматривает новостные сайты, сортируя найденную информацию по темам, определяет степень похожести текстов и формирует новость в виде комментария из пяти предложений. Примерно 88% из тех, кто использовал это решение, признают, что намного удобнее работать с этой программой, чем "ходить" по различным Web-сайтам в поисках новостей.

Следует заметить, что проблема работы с огромным количеством информации имеет два аспекта: один - это автоматический сбор информации (на что, собственно, и ориентированы упомянутая выше система и аналоги), а другой - автоматический разбор поступившей информации по данной тематике, проведенный на основе анализа текста документа.

Согласно А. Харламову , существующие подходы к анализу текстов можно разбить на два класса. К первому классу предлагается отнести быстрые алгоритмы, не зависящие от языка и предметной области, которые используют статистические методы. Второй класс образуют достаточно изощренные, дающие хороший результат, но сравнительно медленные подходы, зависящие от языка и предметной области и в большинстве своем основанные на лингвистических методах.

Не вызывает сомнения, что наиболее эффективен будет подход, сочетающий в себе быстроту и независимость от языка алгоритмов первого класса с высоким качеством обработки второго.

Из существующих систем, с точки зрения авторов, наиболее интересна система ТЕРМИН-5, использующая лексико-статистический метод рубрицирования текстов. Достоинство лексико-статистического метода - его высокая универсальность, поскольку смысл рубрики в нем определяется только набором обучающих текстов . Система позволяет полностью автоматизировать процесс рубрицирования, обеспечивая настройку на рубрикатор по обучающей выборке текстов и выработку решающего правила отнесения документа к той или иной рубрике. Она ориентирована на рубрикацию реальных потоков текстовых сообщений СМИ .

Вообще говоря, сегмент аналитических систем, ориентированных на математический и статистический анализ различных количественных и качественных показателей, развивается на рынке ПО уже давно. Однако до полного решения задачи анализа огромного объема текстовой информации, содержащейся в печатных изданиях, новостных лентах информационных агентств, на тематических сайтах в Интернете, еще достаточно далеко.

Построение систем авторубрикации

Для решения задачи анализа текстовой информации и последующего автоматического распределения ее по требуемым тематикам необходимо в первую очередь сформировать рубрикатор, т. е. задать список тем или рубрик, наиболее точно характеризующих исследуемую область знаний. Необходимое условие при анализе текста - поддержка работы как с линейным, так и с иерархическим рубрикатором с неограниченным количеством уровней вложенности. Ниже приведен пример линейного рубрикатора, используемого на сайте Lenta.ru:

Кроме того, поскольку направления исследований могут изменяться, то хотелось бы иметь возможность классифицировать один и тот же массив введенной информации по разным тематикам, задаваемым разными рубрикаторами.

В существующих системах обработки текстовой информации распространены два принципиальных подхода: основанные либо на списке ключевых слов, либо на списке терминов (именные группы или словосочетания), отнесенных к рубрике тем или иным способом. Причем подготовительная работа по соотнесению ключевых слов и терминов какой-либо рубрике зачастую проводится экспертами вручную.

В этой статье мы рассмотрим метод, который представляет собой развитие системы ТЕРМИН-5 и позволяет автоматически сформировать список терминов, характеризующий принадлежность текстовой информации определенной рубрике. Такой подход можно назвать шагом на пути к автоматическому семантическому анализу текста. Построение списка характеристических терминов проводится на основе морфологического и синтаксического анализа текста путем выделения нетривиальных существительных и имен собственных в окружении определений с учетом частотности слов в языке.

Построение обучающей выборки

В основе технологии обучения рубрикатора лежит построение обучающей выборки - списка файлов или документов, поставленных в соответствие рубрикам этого рубрикатора. Обучение рубрикатора наиболее эффективно, если использовать короткие информативные тексты с максимальной смысловой нагрузкой. При работе с несколькими рубрикаторами для каждого из них следует сформировать свою обучающую выборку.

Точность построения обучающей выборки можно определить только на этапе проведения тематического анализа текстовой информации, т. е. при вводе ее в базу данных. Поэтому построение обучающей выборки - это итеративный процесс: в зависимости от качества определения тематики при анализе текста обучающую выборку можно корректировать.

Обучение рубрикатора

Процесс обучения рубрикатора заключается в построении некоторого множества терминов, характеризующих принадлежность каждой его рубрике. Список определяющих терминов формируется на основе анализа текста документов, составляющих обучающую выборку, по каждой рубрике отдельно. Каждому выделенному термину присваивается некоторый вес, характеризующий его значимость в тексте. Последующий анализ результатов позволяет уточнить список, понижая значимость пересекающихся понятий и терминов, а зачастую и удаляя их.

Иерархия рубрик вместе со значимыми для каждой рубрики терминами, т. е. обученный рубрикатор, называется авторубрикатором. За счет дополнительных средств, позволяющих эксперту выполнять операции добавления или удаления термина, изменения его веса, можно довольно гибко влиять на результаты работы по формированию определяющих терминов авторубрикатора. Откорректированные результаты обучения хранятся в собственной базе терминов (именных групп), характеризующих каждую рубрику, которая затем используется при автоматическом определении тематики поступающей информации.

Использование рубрикатора

После того, как рубрикатор построен, его можно использовать для анализа поступающих в систему текстовых документов. Для этого текст документа подвергается такой же обработке, как и тексты из обучающей выборки при построении рубрикатора. В результате автоматического морфологического и синтаксического анализа текста получают набор характеристических терминов (именных групп и словосочетаний) с учетом частотности. Этот набор терминов становится входным параметром рубрикатора для соотнесения его с соответствующими наборами каждой из рубрик. На выходе получают оценки релевантности данного текста каждой из рубрик. Постпроцессор может отсекать недостоверные (слабые) и/или выделять надежные (высокие) оценки в соответствии с заданными порогами достоверности.

Описанный выше процесс автоматического определения принадлежности входящей информации той или иной рубрике называется авторубрикацией.

Предварительная обработка информации

В качестве основных источников информации предлагается рассматривать Интернет-СМИ, новостные ленты, электронные документы, печатные издания. В основу обработки поступающих данных положен принцип максимально возможной автоматизации. Это касается как разбора текста документа, так и слежения за поступлением новых документов и их последующего ввода в хранилище информации.

Автоматический анализ текста и определение тематики поступающей информации, независимо от формата ее представления, предлагается выполнять непосредственно перед вводом ее в хранилище, но после проведения предварительной обработки исходных данных.

Необходимым функциональным элементом систем обработки информации должна быть проверка ее на дублирование. Особенно это актуально для Интернет-СМИ, где часто встречается полная перепечатка информации, порой и без ссылки на ее источник. Не менее редки ситуации, когда при перепечатке изменяется только заголовок статьи и дата публикации на сайте. Поэтому предлагается проверять на повторяемость как реквизитную, так и текстовую составляющую вводимого документа.

Интернет-СМИ. Обработка новостей, опубликованных в Интернете, состоит не только в описании структуры сайта и организации процесса загрузки с него новостей, но и в соблюдении правил, установленных на рабочем месте пользователя, в которых указываются расписание и периодичность просмотра сайта, состав реквизитов, сопровождающих новости, учет тематики, определенной на сайте, и т. п.

Новостные ленты. Специфика структуры новостной ленты - наличие многих документов внутри одного текстового файла. Обычно формат представления документов новостной ленты определяется внутри организации, ее подготовившей, что говорит об их многообразии. Обработка новостных лент заключается в автоматическом отслеживании новых поступлений, хранящихся на жестком диске, в определении и разборе формата новостной ленты, выделении отдельных документов, ее составляющих.

Электронные и бумажные документы. Технология работы с бумажными документами начинается обычно с перевода их в электронный вид, т. е. с операции сканирования.

Аналитическая обработка

Различные варианты автоматизации сбора разнородной информации и группировки ее по тематическим составляющим - это лишь первый шаг при работе с потоками информации, поступающей из различных источников. Следующим шагом должен стать анализ информации, наиболее часто подразумевающий составление статистических отчетов (возможно, с элементами прогнозирования) и построение дайджестов, позволяющих сгруппировать и опубликовать данные по выбранной тематике.

Статистические отчеты. Аналитические отчеты, базирующиеся на статистической обработке введенной информации, помогают не только быстро оценить качество имеющихся данных, но и зачастую сделать некоторый прогноз на будущее. Такие отчеты могут строиться как с использованием стандартных статистических пакетов (особенно это касается построения прогнозов), так и в результате экспорта данных в Microsoft Excel.

Построение дайджестов. При формировании дайджеста (сводного отчета) необходимо учитывать, что в нем требуется как наиболее полное представление информации по заданному вопросу (т. е. представление полного текста документа), так и представление только в краткой форме, когда в качестве текстовой информации выбирается аннотация или реферат.

Информационно-аналитическая система "Астарта"

Ниже мы рассмотрим работу описанных выше методов обработки информации на примере информационно-аналитической системы "Астарта" (разработчик - компания Cognitive Technologies, http://www.cognitive.ru). Это программное решение базируется на технологии "Евфрат" и предназначено для сбора, обработки и анализа неструктурированной информации, получаемой из Интернета, печатных материалов, СМИ и других источников. Оно имеет клиент-серверную архитектуру с возможностью публикации на сервере документов, предназначенных для общего пользования, и форматов новостных лент. В системе предусмотрено три разнотипных рабочих места и соответственно три типа пользователей: администратор, эксперт и пользователь.

Администрирование

Помимо стандартных функций управления правами доступа к системе и проведения регламентных работ, на администратора "Астарты" возложены функции публикации на сервере системных реквизитов, общих форматов для новостных лент и рубрикаторов. При создании и корректировке списка пользователей системы, а также установке их прав на работу с ее компонентами можно учитывать структуру предприятия, классификатор должностей, а также связи, характерные для взаимодействия между подразделениями. Все эти компоненты формируются и корректируются администратором из интерфейса системы (рис. 1).

| Рис. 1. Окно администратора системы. |

Назначать права доступа можно как каждому пользователю системы отдельно, так и группе пользователей. В последнем случае для всех пользователей группы автоматически устанавливаются права данной группы. Если пользователь состоит в нескольких группах, то его права расширяются в соответствии с правами, которые он имеет в каждой группе.

Администратор - это выделенный пользователь системы, который не должен иметь прав на выполнение пользовательских функций.

Работа с рубрикатором

Формирование рубрикатора - один из самых важных шагов при подготовке системы к работе, поскольку именно он определяет тематику, по которой будет разбираться входящая информация. Система поддерживает работу с иерархическим рубрикатором неограниченной глубины. Рубрикатор можно создать непосредственно из интерфейса системы или подготовить заранее в произвольном текстовом редакторе и импортировать в систему. При подготовке текста рубрикатора разрешено использовать произвольные разделители уровней иерархии.

За подбор обучающей выборки отвечает либо эксперт системы, либо специалист, выполняющий его функции. Обучающая выборка может состоять как из набора файлов, распределенных по рубрикам, так и из документов, ранее введенных в "Астарту". При этом можно выбрать уровень оценки релевантности принадлежности данной рубрике, установленной при вводе документа в систему. Возможность участия документов системы в формировании обучающей выборки особенно удобна при построении уточняющей выборки.

Качество работы построенного авторубрикатора системы определяется по результатам автоматического определения тематики поступающей информации. Авторубрикация документов проводится на этапе ввода информации в БД. Документам присваивается оценка релевантности, характеризующая принадлежность той или иной рубрике (или нескольким рубрикам). Документы, тематика которых не была установлена, относятся к последней по порядку рубрике рубрикатора (например, "Разное"). При неудовлетворительном качестве определения тематики авторубрикатор следует переобучить, уточнив состав обучающей выборки, и заново рубрицировать тот же набор документов (рис. 2).

|

Рис. 2. Процесс построения рубрикатора. |

Результат работы программы обучения (набор характеристических терминов) доступен для просмотра и корректировки. Эксперту предоставляется возможность откорректировать вес того или иного термина, добавить новый термин или удалить ненужный.

Подготовленный и обученный рубрикатор публикуется на сервере системы или сразу становится доступен для дальнейшей работы (если используется локальная версия системы).

Работа пользователя

Работа пользователя системы начинается с определения списка источников информации, задания расписания работы программы, обрабатывающей Интернет-СМИ, и указания списка директорий, в которых будут скапливаться поступающие новостные ленты. Кроме того, необходимо выбрать рубрикатор. В системе разрешена работа с несколькими рубрикаторами, т. е. любой документ может быть прорубрицирован по нескольким рубрикаторам, однако текущим в каждый момент времени должен быть один рубрикатор.

По умолчанию система настроена так, что один документ одновременно рубрицируется по нескольким рубрикам. Однако существует возможность - и это удобно при составлении статистических отчетов - настроить авторубрицирование по принадлежности документа только одной рубрике.

Ввод документов

Система ввода поддерживает автоматический просмотр новостных страниц заранее указанных сайтов с заданной периодичностью и в соответствии с составленным расписанием. Применение системы расписаний позволяет распределить работу по вводу новостей, относя ее, например, на ночное или обеденное время.

Предварительная обработка новостной Интернет-страницы заключается в выделении отдельных новостей из новостного блока и разбора структуры каждой новости, т. е. в выделении текстового фрагмента и списка реквизитов, его сопровождающих. Подготовленные таким образом новости передаются системе ввода, в процессе работы которой проводится проверка на дублирование информации, а затем авторубрикация ее текста. Повторные документы в систему не вводятся. Вся информация о работе с Интернет-СМИ отражается в специальном протоколе.

При обработке новостных лент различных форматов в первую очередь определяется формат данной ленты. Заметим, что в одном потоке могут находиться новостные ленты различных форматов. Затем из новостной ленты выделяются отдельные новости, которые передаются системе ввода. Новостные ленты, формат которых системе не удалось определить автоматически, собираются в заранее указанном месте. В дальнейшем можно вручную указать формат, по которому их следует вводить. Кроме того, предусмотрена возможность ввода в "Астарту" так называемых неформатных документов, т. е. документов, формат которых в системе не описан. Указание, что сейчас будет вводиться поток неформатных документов, делается вручную.

Для обработки бумажных документов в системе есть возможность запустить программу сканирования и указать в ее интерфейсе место расположения полученных графических образов документов. Последующий ввод таких документов в систему выполняется вручную, с использованием дополнительной возможности распознавания текста документа "на лету" (drag&recog) при заполнении реквизитов документа. Возможна также автоматическая полнотекстовая индексация графического документа путем "слепого" распознавания всего графического образа и передачи распознанного текста модулю полнотекстовой индексации.

Поиск документов

Разветвленная поисковая система программного комплекса "Астарта" (рис. 3) обеспечивает составление сложных запросов, поддерживая организацию полнотекстового, контекстного и реквизитного поиска документов, причем как по локальному, так и по серверному хранилищу данных. При организации поиска используются методы морфологического анализа, позволяющие находить в тексте документа не только точно указанное слово (или словосочетание), но и все его словоформы. Поиск с учетом морфологии можно проводить как по тексту документа, так и по его реквизитам.

|

| Рис. 3. Формирование запроса на поиск документов. |

Интерфейс системы позволяет формировать запросы с использованием логических операций И, ИЛИ, НЕ, указывая тем самым более точное условие для поиска информации. Имеется также ряд средств и функций, упрощающих работу по формированию запроса на поиск документов:

- наличие словарей при реквизитах системы (упрощает выбор необходимого значения);

- возможность указания даты на "естественном" языке (например, выбор даты "март 2003 г." равносилен указанию интервала с 1.03.03 по 31.03.03);

- формирование запроса по результатам поиска;

- хранение предопределенных запросов.

Формирование дайджестов

Формирование сводных отчетов (дайджестов), сгруппированных по различным информационным срезам, - неотъемлемая часть функциональных возможностей системы (рис. 4). Для реализации этой возможности в системе "Астарта" имеется компонент, позволяющий создавать различные шаблоны представления информации в отчетах, где задаются стили и структура всех составных частей отчета и указывается способ сортировки документов. Имеющиеся настройки позволяют составить дайджест только по аннотации документов или сформировать полнотекстовый дайджест. При больших объемах информации можно сформировать многотомный документ или же, наоборот, только оглавление для него.

|

| Рис. 4. Формирование сводного отчета (дайджеста). |

По умолчанию итоговый документ создается в формате Microsoft Word, однако можно выбрать и другой формат представления данных на этапе заполнения шаблона.

Построение статистических сводок

Основная задача статистического анализа состоит в том, чтобы определить тенденции развития исследуемой проблемы. Наиболее наглядные способы представления результатов - временной ряд, показывающий развитие исследуемой величины с течением времени, и диаграмма, показывающая долю исследуемой величины относительно других величин. Если для решения задач прогнозирования требуется применение различных статистических пакетов, использующих специальные алгоритмы (например, алгоритм авторегрессии и интегрального скользящего среднего АРИСС - ARIMA), то качественную оценку, полученную на основании построенных временных рядов, можно получить с помощью стандартного пакета Excel.

В системе "Астарта" реализованы оба способа построения различных статистических сводок: с использованием возможностей пакета Statistica 5.5 либо стандартного пакета Excel. При экспорте в Excel из интерфейса системы можно указать тип представления информации: график, круговая диаграмма или таблица. Пример временного ряда, построенного с использованием пакета Excel для рубрикатора сайта Lenta.ru, приведен на рис. 5.

Заключение

Информационным и аналитическим службам предприятий в своей работе приходится сталкиваться с самыми разнообразными источниками информации. Это бумажные периодические издания, электронные газеты, другие Интернет-ресурсы, электронная почта, передача новостных потоков по IP- и ftp-каналам и т. п. Использование описанной в статье технологии обработки и анализа информации, поступающей из разнородных источников, с автоматической группировкой по тематическим признакам сводит к минимуму вероятность пропустить необходимые сведения. Автоматическая фильтрация потоков позволяет оперативно получать интегральную информационную картину, а для детального изучения поступающей информации может использоваться мощный поисковый механизм с построением сложных запросов.

Опыт внедрения информационно-аналитической системы в различных организациях показал высокую эффективность и простоту адаптации системы к местным условиям благодаря разработанному универсальному инструменту автоматизированной загрузки больших, разнородных по структуре потоков текстовой информации.

Универсальный разборщик форматов дает возможность полностью автоматизировать ввод электронных информационных потоков из гетерогенных источников с приведением информации к единому внутреннему представлению, а также свести к минимуму рутинную работу по вводу нерегулярных текстовых данных (например, ввод текстов с бумажных носителей при распознавании статей из печатных СМИ, конспектирование, а в перспективе и автоматическое распознавание текущей аудиоинформации и т. п.). Встроенная система автоматического слежения за публикацией "свежих" новостей на информационных сайтах в Интернете позволяет автоматизировать и эту часть деятельности информационных и аналитических служб предприятий.

Важное обстоятельство - гибкость предложенной технологии авторубрикации (тематической фильтрации). Построение списка рубрик и обучение системы может выполнять эксперт - специалист информационно-аналитической службы конкретного предприятия - для нужд специализированного информационно-аналитического обслуживания. Диапазоны достоверных оценок релевантности документов заданным рубрикам также должны быть доступны эксперту в качестве инструмента анализа или самообучения системы на свежих данных.

Аналитический блок служит для автоматизации процесса подготовки отчетов и дайджестов, а также позволяет аналитику отслеживать и давать прогноз отражения в публичном информационном пространстве (СМИ, Интернет,..) различных тенденций развития конкретной предметной области.

Эффективность информационно-аналитических систем такого класса может быть повышена благодаря развитию и внедрению методов искусственного интеллекта в применении к анализу текстов, в частности, методов автоматического семантического анализа текстов, понимания смысла.

УДК 621. 37/39. 061. 2/4

МЕТОДЫ АНАЛИТИЧЕСКОЙ ОБРАБОТКИ ИНФОРМАЦИИ

ГВОЗДИНСКИЙА.Н., КЛИМКО Е.Г., СОРОКОВОЙ А.И.

Проводится аналитический обзор методов интеллектуального анализа данных (также называют: ИАД, data mining, обнаружение знаний в базах данных) с учетом использования определенного метода для условий Украины. Обзор методов аналитической обработки информации в сложных информационных системах рассматривается с точки зрения скорости извлечения данных, сбора обобщенной информации и повышения достоверности процесса.

Процесс интеллектуального анализа данных - это аналитическое исследование больших обьемов информации в целях определения закономерностей и взаимосвязей между переменными, которые можно в дальнейшем применить к новым данным. Полученные сведения преобразуются до уровня информации, которая характеризуется как знание. Этот процесс состоит из трех основных этапов :

Исследование (выявление закономерностей);

Использование выявленных закономерностей для построения модели;

Анализ исключений для обнаружения и объяснения отклонений в найденных закономерностях.

Нахождение нового знания средствами ИАД - новое и быстро развивающееся направление, использующее методы искусственного интеллекта, математики, статистики. Этот процесс включает в себя следующие шаги :

Определение проблемы (постановка задачи);

Подготовка данных;

Сбор данных: оценка их, объединение и очистка, отбор и преобразование;

Построение модели: оценка и интерпретация, внешняя проверка;

Использование модели;

Наблюдение за моделью.

Построить модель и улучшить ее качество помогает формальная проверка данных с помощью последовательности запросов или предварительного интеллектуального анализа данных. Средства такого анализа включают следующие основные методы: нейронные сети, деревья решений, генетические алгоритмы, а также их комбинации .

Нейронные сети относят к классу нелинейных адаптивных систем, строением они условно напоминают нервную ткань из нейронов.